KI-Projekte outsourcen: Wer haftet wirklich, wenn der GPT Fehler macht?

Ein Szenario, das jeden KI-Berater nachts wach hält:

Sie entwickeln einen Custom GPT für einen Kunden. Der GPT soll Kostenvoranschläge erstellen. Sie liefern saubere Arbeit, dokumentieren alles, übergeben das Tool.

Drei Monate später: Der GPT spuckt einen falschen Preis aus. Der Endkunde nimmt an. Der Auftraggeber macht Verlust. Und plötzlich steht eine Schadensersatzforderung im Raum.

Wer zahlt? Sie als Entwickler? Der Auftraggeber, der das Tool einsetzt? Oder gar beide?

Diese Frage ist nicht theoretisch. Sie ist existenziell für jeden, der KI-Tools für andere entwickelt. Und die Antwort ist komplizierter, als die meisten denken.

Die unbequeme Wahrheit: KI kann nicht haften

Fangen wir mit dem Offensichtlichen an: Eine KI hat keine Rechtspersönlichkeit. Sie kann nicht verklagt werden, nicht zahlen, nicht verantworten. Das bedeutet: Wenn ein KI-System einen Schaden verursacht, muss immer ein Mensch oder ein Unternehmen haften.

Die Frage ist nur: welcher?

Das deutsche Recht kennt verschiedene Anspruchsgrundlagen, die bei KI-Schäden relevant werden können:

| Anspruchsgrundlage | Typische Konstellation | Praxisrelevanz für KI-Projekte |

|---|---|---|

| Vertragshaftung | Zwischen Entwickler und Auftraggeber | Hauptspur bei Projektschäden wie Fehlkalkulationen |

| Deliktshaftung (§ 823 BGB) | Gegenüber Dritten | Bei Rechtsverletzungen, Unterlassungsansprüchen |

| Produkthaftung | Bei fehlerhaften Produkten | Primär bei Personen-, Sach- und teils Datenschäden |

| Organisationsverschulden | Beim Betreiber | Fehlende Schulung, Prüfung, Kontrolle |

Wichtig: Für typische Projektschäden wie entgangener Gewinn oder Fehlkalkulationen ist meist die Vertragshaftung entscheidend. Die Produkthaftung wird besonders relevant bei Personen- und Sachschäden – reine Vermögensschäden sind dort nicht der Kern.

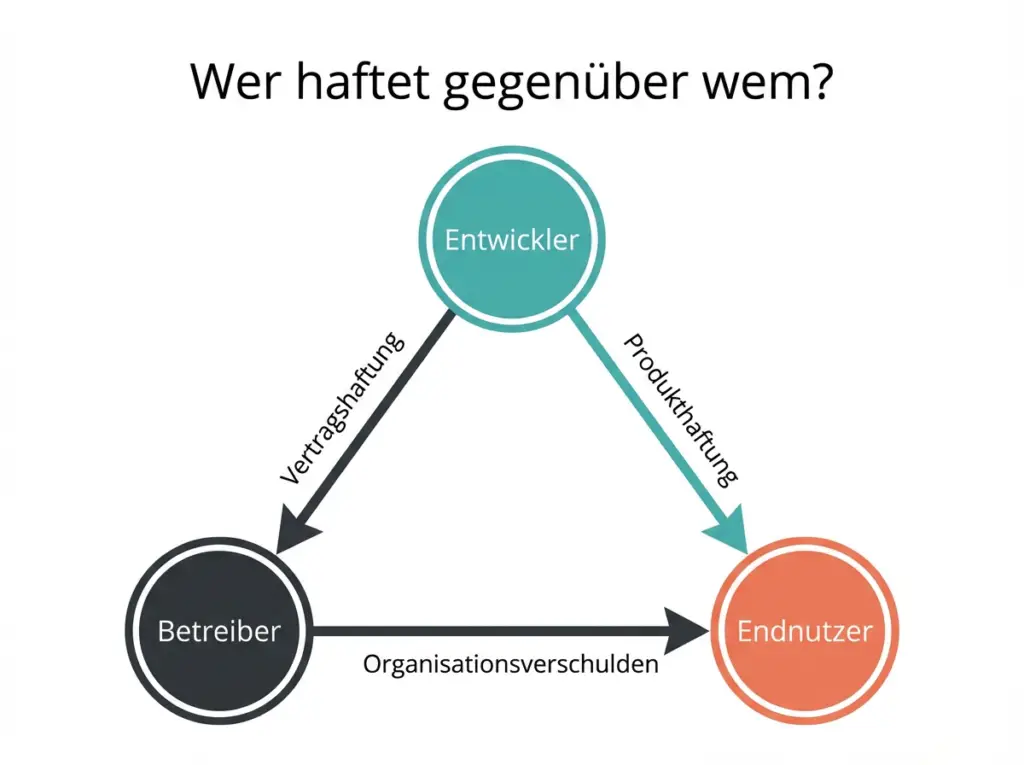

Das Haftungsdreieck: Entwickler, Betreiber, Endnutzer

Bei einem typischen KI-Projekt gibt es mindestens drei Parteien:

1. Der Entwickler (Sie) Sie bauen den Custom GPT, trainieren ihn, konfigurieren die Prompts, dokumentieren die Einschränkungen.

2. Der Betreiber (Ihr Auftraggeber) Das Unternehmen, das den GPT entweder intern oder gegenüber Kunden einsetzt.

3. Der Endnutzer Der Mitarbeiter, der den GPT bedient, oder der Kunde, der damit interagiert.

Wann haftet der Entwickler?

Sie als Entwickler haften, wenn:

- Das KI-System technisch fehlerhaft ist: Ein Bug, ein Logikfehler, eine fehlerhafte Konfiguration, die zu falschen Ergebnissen führt.

- Die Dokumentation unzureichend ist: Sie haben nicht klar kommuniziert, wofür das Tool geeignet ist und wofür nicht.

- Sie Sicherheitsmängel eingebaut haben: Das System ist anfällig für Manipulation, Prompt Injection oder Datenlecks.

- Sie zugesicherte Eigenschaften nicht eingehalten haben: Der GPT kann nicht, was er laut Vertrag können sollte.

Die neue EU-Produkthaftungsrichtlinie (Richtlinie 2024/2853, umzusetzen bis Dezember 2026) erfasst Software explizit als „Produkt“ und verschärft die Lage bei Personen-, Sach- und teils Datenschäden. Aber: Reine Vermögensschäden wie entgangene Gewinn aus einem falschen Kostenvoranschlag sind im Produkthaftungsregime typischerweise nicht der Kern. Hier bleibt die Vertragshaftung die Hauptspur.

Wann haftet der Betreiber?

Der Betreiber (Ihr Auftraggeber) haftet, wenn:

- Er das Tool ohne Prüfung einsetzt: Wer KI-generierte Ergebnisse ungeprüft übernimmt, handelt fahrlässig.

- Seine Mitarbeiter nicht geschult sind: Der AI Act (Artikel 4, in Kraft seit 2. Februar 2025) verlangt von Anbietern und Betreibern, die KI-Kompetenz ihrer Mitarbeiter sicherzustellen. Praktisch heißt das für den Betreiber: Schulung, Richtlinien und nachweisbare Kontrollen.

- Er das Tool außerhalb der Zweckbestimmung einsetzt: Ein GPT für interne Recherche wird plötzlich für verbindliche Kundenangebote genutzt.

- Er keine menschliche Kontrolle eingerichtet hat: Kritische Entscheidungen werden rein KI-gestützt getroffen.

Die entscheidende Frage: Fehler, Grenze oder Nutzungsproblem?

Hier liegt der Kern des Haftungsrisikos. Bei KI-Systemen gibt es nicht nur zwei, sondern drei Kategorien:

1. Echter Fehler (Entwicklerverantwortung) Ein Bug, eine falsche Logik, fehlerhafte Trainingsdaten, eine kaputte Konfiguration. Der GPT rechnet systematisch falsch oder stürzt ab. Das ist ein klassischer Produktfehler.

2. Systemgrenze (Grauzone) LLMs haben bekannte Einschränkungen, die kein „Fehler“ im technischen Sinn sind: Halluzinationen, Nicht-Determinismus (gleiche Eingabe, verschiedene Ausgaben), Kontextlücken. Diese Grenzen sind dokumentierbar, aber nicht vollständig vermeidbar. Hier wird Erwartungsmanagement entscheidend.

3. Nutzungsfehler (Betreiberverantwortung) Der Nutzer gibt unvollständige Informationen ein, ignoriert Warnhinweise, verwendet das Tool außerhalb der Zweckbestimmung oder übernimmt Ergebnisse ohne Prüfung.

Das Problem bei KI: Die Grenzen zwischen diesen Kategorien sind oft nicht eindeutig. War der falsche Kostenvoranschlag ein Systemfehler, eine bekannte Grenze des Modells, oder hat der Nutzer schlecht promptiert? Das ist im Streitfall schwer nachzuweisen – und genau deshalb ist Dokumentation so wichtig.

Praxisbeispiel:

Ein Dachdeckerbetrieb nutzt einen KI-gestützten Kostenvoranschlags-Generator. Der Mitarbeiter, der das Tool bedient, wurde nie geschult. Der GPT liefert einen fehlerhaften Preis, der Kunde nimmt an, der Betrieb macht Verlust.

Frage des Anwalts: „War der Mitarbeiter im Umgang mit dem KI-System geschult?“

Antwort: „Nein.“

Das ist der Moment, in dem aus einem technischen Fehler ein Haftungsfall wird. Der Schaden hätte durch angemessene Schulung und Prüfung vermieden werden können, der Betrieb hat seine Sorgfaltspflicht verletzt.

Ein wichtiges Urteil: Das Landgericht Kiel entschied im Februar 2024 (Az. 6 O 151/23): Auch bei KI-gestützter Automatisierung bleibt der Betreiber verantwortlich. Er kann sich nicht darauf zurückziehen, nur fremde Daten ungeprüft veröffentlicht zu haben. Die Kernbotschaft: Automatisierung schützt nicht vor Verantwortung.

Werkvertrag oder Dienstvertrag? Die unterschätzte Weichenstellung

Für KI-Projekte ist diese Frage nicht akademisch, sondern haftungsrelevant:

Werkvertrag-Logik: Sie schulden ein bestimmtes Ergebnis. Der Kunde hat Mängelrechte, es gibt eine Abnahme-Logik. Wenn das Ergebnis nicht funktioniert, haften Sie.

Dienstvertrag-Logik: Sie schulden sorgfältige Tätigkeit, nicht ein garantiertes Ergebnis. Die Haftung ist enger begrenzt.

Warum das für KI wichtig ist: Ein GPT, der „Kostenvoranschläge erstellen soll“, klingt nach Werkvertrag. Aber kann man bei einem LLM ein fehlerfreies Ergebnis zusichern? Die Antwort beeinflusst Ihre Haftung massiv.

Empfehlung: Formulieren Sie Verträge so, dass klar ist: Sie liefern ein Werkzeug mit dokumentierten Grenzen, nicht eine Garantie auf korrekte Ergebnisse. Die Prüfpflicht liegt beim Betreiber.

Schadensbegrenzung in der Praxis

Selbst wenn ein KI-System einen Fehler produziert, muss das nicht zum vollen Schaden führen. Smarte Betreiber bauen Sicherheitsnetze ein:

Freigabeprozess: Das KI-generierte Angebot ist erst nach menschlicher Freigabe verbindlich.

Output-Disclaimer: „Entwurf, vorbehaltlich Prüfung durch Fachpersonal.“

Anfechtung und Korrektur: Je nach Konstellation kann ein offensichtlicher Preisirrtum rechtlich Folgen begrenzen.

Für Sie als Entwickler: Wenn der Auftraggeber keine menschliche Kontrolle und keinen verbindlichen Prüfprozess akzeptiert – mit dem KI-Outputs zu Entwürfen degradiert werden – ist das ein Projekt mit strukturellem Haftungsstress. Dann: Preis hoch, Scope runter, oder Nein sagen.

Können Sie sich versichern?

Ja, und das sollten Sie dringend tun.

IT-Haftpflichtversicherung (Berufshaftpflicht)

Die IT-Haftpflicht ist die wichtigste Absicherung für KI-Entwickler. Je nach Police und Anbieter kann sie abdecken:

- Vermögensschäden: Finanzielle Verluste beim Kunden durch Softwarefehler

- Programmierfehler: Auch nicht reproduzierbare Fehler

- Beratungsfehler: Falsche Empfehlungen zur KI-Implementierung

- IP-Risiken: Urheberrechts- und Lizenzverletzungen (oft mit Sublimits)

- Datenschutz: DSGVO-Verstöße (häufig über separaten Cyber-Baustein)

Kosten: Oft ab niedrigem dreistelligen Betrag pro Jahr, abhängig von Umsatz, Deckungssumme und Selbstbehalt. Anbieter wie ERGO, Hiscox, AXA oder NÜRNBERGER bieten spezielle IT-Policen an.

Wichtig: Prüfen Sie genau, was Ihre Police abdeckt. ERGO bietet beispielsweise eine Vermögensschadenhaftpflicht speziell für IT- und EDV-Dienstleister, Hiscox bewirbt ein explizites „KI-Cover“ für Entwicklung und Beratung zu KI-Anwendungen. Aber: Lesen Sie Ausschlüsse und Sublimits. Nicht jede IT-Haftpflicht deckt automatisch alle KI-Risiken ab.

Was die Versicherung NICHT abdeckt

- Vorsätzliche Pflichtverletzungen: Wenn Sie wissentlich Fehler einbauen

- Erfüllungsansprüche: Die Versicherung zahlt nicht Ihr Honorar, wenn der Kunde unzufrieden ist

- Vertragsstrafen und Bußgelder: Nur Schadensersatz, keine Strafen

Deckungssummen

Für KI-Projekte empfehle ich mindestens 500.000 Euro Deckungssumme für Vermögensschäden. Bei größeren Projekten mit hohem Schadenspotenzial entsprechend mehr.

Wie Sie sich vertraglich absichern

Eine Versicherung ist sinnvoll. Besser ist es jedoch, Haftungsfälle von vornherein zu vermeiden oder zumindest klar zu regeln, wer wofür verantwortlich ist.

Im Vertrag regeln

1. Rollen klarstellen

„Auftragnehmer agiert als Entwickler/Anbieter im Sinne des AI Act. Auftraggeber übernimmt als Betreiber die Verantwortung für Schulung der Mitarbeiter, ordnungsgemäßen Einsatz und Überprüfung der Ergebnisse.“

2. Zweckbestimmung begrenzen

„Das KI-System ist ausschließlich für „konkreten Zweck“ vorgesehen. Eine Nutzung für andere Zwecke erfolgt auf alleiniges Risiko des Betreibers.“

3. Prüfpflicht des Betreibers festschreiben

„Der Betreiber verpflichtet sich, alle Ausgaben des KI-Systems vor geschäftskritischer Verwendung durch fachkundiges Personal zu überprüfen.“

4. Haftungsbegrenzung vereinbaren

„Die Haftung des Auftragnehmers ist auf „Betrag/Auftragswert“ begrenzt. Diese Begrenzung gilt nicht bei Vorsatz oder grober Fahrlässigkeit.“

Achtung: Pauschale Haftungsausschlüsse wie „Wir haften nicht für KI-generierte Inhalte“ sind in AGB rechtlich oft unwirksam.

Bei Übergabe dokumentieren

- Betriebsanleitung erstellen: Was kann das Tool, was nicht?

- Einschränkungen dokumentieren: Bekannte Grenzen und Fehlerquellen

- Schulungspflicht hinweisen: Schriftlich darauf aufmerksam machen, dass der Betreiber seine Mitarbeiter schulen muss

- Übergabeprotokoll unterschreiben lassen: Kunde bestätigt, dass er die Einschränkungen kennt

Mögliche Haftungsverteilung:

| Szenario | Wer haftet? | Anspruchsgrundlage |

|---|---|---|

| Systematischer Rechenfehler im GPT | Entwickler | Vertragshaftung (Schlechterfüllung) |

| Nutzer hat falsche Eingabedaten verwendet | Betreiber | Organisationsverschulden |

| GPT hat korrekt gerechnet, aber Nutzer hat Ergebnis nicht geprüft | Betreiber | Verletzung der Prüfpflicht |

| Bekannte Systemgrenze (Halluzination), aber nicht dokumentiert | Entwickler | Dokumentationsmangel |

| Keine Schulung, keine Dokumentation, keine Prüfung | Beide anteilig | Geteilte Verantwortung |

In der Praxis: Wenn beide Seiten Fehler gemacht haben, wird oft ein Vergleich angestrebt. Die Versicherungen verhandeln, und am Ende zahlt jede Seite einen Teil.

Meine Empfehlung: So minimieren Sie Ihr Risiko

Als Entwickler

- IT-Haftpflicht abschließen – Mindestens 500.000 Euro Deckungssumme für Vermögensschäden

- Sauber dokumentieren – Jedes System braucht eine Betriebsanleitung mit klaren Grenzen

- Vertraglich absichern – Rollen, Zweckbestimmung, Prüfpflichten schriftlich regeln

- Schulungsnachweis fordern – Vor Übergabe bestätigen lassen, dass der Betreiber seine Pflichten kennt

- Keine Zusicherungen machen, die Sie nicht halten können – „Der GPT macht keine Fehler“ ist eine gefährliche Aussage

Was Sie NICHT tun sollten

- Projekte ohne Versicherung annehmen – Das Risiko ist zu hoch

- Pauschal alles zusichern – Seien Sie ehrlich über die Grenzen von KI

- Undokumentiert übergeben – Im Streitfall fehlt Ihnen der Beweis

- Auf „der Kunde wird schon prüfen“ vertrauen – Er wird es nicht tun

Sonderfall: Sie entwickeln, der Kunde gibt an Dritte weiter

Besonders heikel wird es, wenn Ihr Auftraggeber das KI-Tool an seine eigenen Kunden oder Partner weitergibt.

Der regulatorische Hintergrund: Artikel 25 AI Act regelt Verantwortlichkeiten entlang der KI-Wertschöpfungskette – allerdings primär für Hochrisiko-KI-Systeme. Viele Custom GPTs für Kostenvoranschläge fallen nach heutigem Verständnis nicht automatisch in diese Kategorie.

Trotzdem relevant: Wenn das System als Hochrisiko eingestuft wird oder der Kunde es durch Zweckänderung in diese Richtung schiebt. kann er regulatorisch zum Anbieter werden. Das passiert beispielsweise bei:

- Inverkehrbringen unter eigenem Namen oder eigener Marke

- Wesentlichen Änderungen am System

- Änderung der Zweckbestimmung (z.B. von „intern“ zu „kundenwirksam“)

Für Sie als Entwickler bedeutet das:

- Klären Sie im Vertrag, ob und wie das Tool weitergegeben werden darf

- Wenn ja, muss der Auftraggeber die entsprechenden Pflichten übernehmen

- Dokumentieren Sie, dass Sie auf diese Konstellation hingewiesen haben

- Bei Unsicherheit über die Risikoklasse: rechtliche Prüfung empfehlen

Das Risiko ist real, aber beherrschbar

KI-Entwicklung für Kunden ist kein risikoloses Geschäft. Aber mit der richtigen Absicherung ist das Risiko kalkulierbar:

- IT-Haftpflichtversicherung – Ihre erste Verteidigungslinie

- Klare Verträge – Rollen und Verantwortlichkeiten schriftlich regeln

- Saubere Dokumentation – Grenzen und Einschränkungen transparent machen

- Schulungshinweise – Betreiber auf seine Pflichten aufmerksam machen

Das Ziel ist nicht, jede Haftung auszuschließen. Das funktioniert nicht. Das Ziel ist, im Schadensfall nachweisen zu können, dass Sie Ihre Sorgfaltspflichten erfüllt haben.

Häufige Fragen zur KI-Haftung

Kann ich als Entwickler komplett von der Haftung befreit werden? Nein. Eine vollständige Haftungsbefreiung ist bei Vorsatz und grober Fahrlässigkeit nicht möglich. Aber Sie können die Haftung auf bestimmte Summen begrenzen und klar regeln, wofür Sie verantwortlich sind und wofür der Betreiber.

Reicht eine normale Berufshaftpflicht? Meistens nicht. Sie brauchen eine IT-Haftpflicht, die Vermögensschäden abdeckt. Normale Berufshaftpflichtversicherungen decken oft nur Personen- und Sachschäden ab.

Was kostet eine IT-Haftpflicht? Oft ab niedrigem dreistelligen Betrag pro Jahr, abhängig von Umsatz, Deckungssumme und Selbstbehalt. Vergleichen Sie Angebote und prüfen Sie genau, was abgedeckt ist.

Haftet OpenAI nicht als Anbieter des Basismodells? Teilweise. OpenAI haftet für Fehler im Basismodell (GPT-4 etc.). Aber wenn Sie einen Custom GPT bauen, sind Sie für Ihre Konfiguration, Ihre Prompts und Ihre Dokumentation verantwortlich.

Muss ich meinen Kunden auf die Schulungspflicht hinweisen? Rechtlich nicht zwingend. Aber es schützt Sie im Streitfall, wenn Sie nachweisen können, dass der Kunde seine Pflichten kannte.

Was, wenn der Kunde keine Versicherung hat und nicht zahlen kann? Dann bleibt der Schaden möglicherweise an Ihnen hängen, wenn Sie mitverantwortlich sind. Ein Grund mehr, nur mit seriösen Auftraggebern zu arbeiten und im Zweifel Vorkasse zu verlangen.

Sie planen ein KI-Projekt und wollen Ihr Haftungsrisiko minimieren?

In einem kostenlosen Erstgespräch analysieren wir gemeinsam Ihr Setup und entwickeln eine Absicherungsstrategie.

Post Tags :

Share :

Custom GPTs Unternehmen, ChatGPT Enterprise Grenzen, Custom GPTs Datenschutz, Vendor Lock-in OpenAI, On-Premises KI, Enterprise Search, auraHub Alternative, KI Plattform Vergleich, Micro Apps vs Custom GPTs, DSGVO KI Compliance, Rechtesteuerung KI, Unternehmensweite KI, KI Implementierung

Weitere Beiträge zum Thema

Individuelle Anweisungen für KI. Wie Sie ChatGPT und Claude optimal nutzen, um bessere Ergebnisse zu erzielen.

KI-Plattform für Unternehmen. KI-Plattform mit Micro Apps und Enterprise Search für strukturierte KI-Nutzung.

KI Governance pragmatisch gedacht. Wie Sie KI-Richtlinien einführen, ohne Innovation zu ersticken.

KI-Agenten im Mittelstand und Handwerk. Wie KI-Agenten Routineaufgaben automatisieren und Zeit sparen.